{{item.title}}

{{item.text}}

{{item.text}}

本稿では、企業がAIを利活用するにあたって果たすべき10のAI原則を提唱し、AIの利点を活用すると同時に、そのリスクを低減する方法について解説します。

過去6年間における検索ワードのトレンドを調べてみると、「AI倫理」「倫理AI」「有益なAI」「信頼できるAI」「責任あるAI」というワードが非常に注目を集めていることがわかります。AIがビジネスで利用され始めた1980年代から90年代においては、倫理についての議論は学会の片隅で細々と行われているだけで、ビジネスの世界で話題にあがることは決してありませんでした。しかしながら、近年のAIの導入状況とAIの実質的なリスクの双方を考えると、これらの用語がトレンドになっていることは驚くべきことではありません。

では、「AI倫理」「倫理AI」「有益なAI」「信頼できるAI」「責任あるAI」といった用語は実際にどのような意味を持つのでしょうか。また、誰がこのような用語を考え出したのでしょうか。特に、AIの積極的に利用を推進しているテクノロジー企業やそれ以外の企業において、これらの用語は何を意味するのでしょうか。

「名前とは何を意味するのでしょうか。私たちが「バラ」と呼ぶ対象は、他の呼び方に変えたとしても、甘い香りがすることに変わりはありません」

上記の文章は、ウィリアム・シェイクスピアの戯曲「ロミオとジュリエット」の有名なセリフです。私たちがAIにおいて原則と呼ぶ名称は本当にこれで良いのでしょうか。例えば、「責任あるAI」という名称は「信頼できるAI」「倫理的なAI」「有益なAI」などに変えても問題ないでしょうか。いいえ、この答えには明らかに問題があります。私たちが名付けた諸原則は、その名前自体に実質的に重要な意味を持っています。

デジタルコンピューターを最初に考案した18世紀の英国の数学者であり、発明家でもあるチャールズ・バベッジの発言の方が、その意図がより分かりやすいかもしれません。

「名前にはどのような意味が含まれていますか。あなたが名前に何かしらの意味合いを加えるまでは、名前自体は単なる空っぽの箱でしかありません」

10年程前まではAIにおける一連の原則は「単なる空っぽの箱」の状態でしたが、今日では非常に具体的な意味を持っています。この箱に該当する名称と、それが持つ意味はどういったものかを見てみましょう。

信頼できるAI:欧州委員会の「AIに関するハイレベルな専門家グループ」(HLEG-AI)は、信頼できるAIを「合法的なAI(適用されるすべての法律および規制に準拠)、倫理的なAI(倫理原則と価値の遵守を担保)、および堅牢なAI(意図しない危害を引き起こさない)」と定義しています。

倫理的なAI:EUの観点からは、倫理的なAIは「信頼できるAI」に含まれます。倫理原則は、人間の尊厳の尊重、個人の自由、民主主義の尊重、正義と法の支配、平等、無差別と連帯、市民の権利という基本的権利から導出されます。これらの基本的権利から、HLEG-AIは4つの倫理原則を以下のとおり提案しています。

HLEG-AIは、これらの原則の間に緊張関係があり、それらの間のトレードオフを特定し、評価したうえで、それらに基づいて行動する必要があることも伝えています。

有益なAI:この概念について、HLEG-AIでは定義や詳細な検討を行っていません。有益なAIという概念は、アシロマの原則の1つに起源があります。2017年のアシロマ会議において、AIの研究目標は「無秩序な知能ではなく、有益な知能を生み出すこと」と定義されました。「有益な」という言葉には、さらに詳しい検討が求められます。例えば、「誰にとって有益なのか。人類全体か、その一部か、AIに出資する会社株主か」「いつ有益になるのか。現在か、今から10年後か」「有益性を誰が判断するのか」などの検討が必要です。スチュアート・ラッセルは、人間にとっての有益性を証明可能な概念としてAIを紹介しています。ラッセルによれば、「機械は、その行動が人間の目的を達成するものと期待できる限りにおいて有益である」ということになります。ここでの焦点は、AIの価値を人間にとっての価値と整合させることであり、AIに人間の価値を学習させることです。「証明可能」という概念は、私たちが現在持ち合わせているあるものではなく、今後目指すべきものを強く示していると言えます。

上述の定義から、倫理的なAIは信頼できるAIの意味合いの中に含まれることが分かります。しかしながら、有益なAIと倫理的なAIとの関係は、定義上で明らかになっていません。では、4原則により定義された意味合いの中で、倫理的でありながらも有益でないAIは存在するのでしょうか。逆に、有益ではあるが倫理的でないAIは存在し得るのでしょうか。

これら2つの問いに対する回答は、上記の定義と、定義に内在するトレードオフを私たちがどう解釈するかにより、いずれの場合でも「あり得る」と肯定的に解釈できる可能性があります。4原則を尊重した倫理的なAIであっても、人間の目的を実現しない形で構築されてしまうことは、どうしてもあり得ます(例えば、宇宙探査を目的とするAIプロジェクトは、人間の自律性尊重や危害防止などに則って実行されたとしても、少数の宇宙愛好家を除いた大多数の人間にとっては有益性がないでしょう)。同様に、基本的権利や倫理的原則を必ずしも全て尊重していなかったとしても、有益なAIが存在する可能性があります(例えば、パンデミック時に人間の移動を厳しく制限するAIは、多くの人命を救う効果があるとしても、個人の自由を制限することになります)。

HLEG-AIのドキュメントには、AIの4つの倫理原則だけでなく、信頼できるAIを実現するための7つの重要な要件も示されています。これらの要件は、エンドユーザー、開発者、企業、社会全体など、AIモデル開発ライフサイクルにおけるさまざまな段階で関与する利害関係者に対応しています。HLEG-AIの7つの要件は次のとおりです。

(a)人間による介在および監視

(b)技術的な堅牢性と安全性

(c)プライバシーとデータガバナンス

(d)透明性

(e)多様性、無差別および公平性

(f)社会的および環境的幸福

(g)説明責任

これら7つの要件には、主要な基本的権利と倫理原則が取り込まれています。初期の段階から信頼されているシステムはありません。信頼を獲得するために、システムはこれらの7つの原則を明確に反映する必要があります。

これまでの議論をまとめると、信頼できるAI(倫理的なAIを含む)と有益なAIの2つの異なる概念があることが分かりました。それでは、次に責任あるAIを見てみましょう。

リマとチャによると責任あるAIという名称に含まれている「責任ある」という言葉には、関連する3つの異なる意味があります。

信頼できるAIは、人間による介在と監視に対して、要件によっては非難に値する考え方を示しています。また、人間による介在と監視について、ヒューマン・イン・ザ・ループ(HITL:Human-in-the-Loop)、ヒューマン・オン・ザ・ループ(HOTL:Human-on-the-Loop)、ヒューマン・イン・コマンド(HIC:Human-in-Command)といったガバナンス手法による監視を提案しています。説明責任は、信頼できるAIにおける明示的な要件であり、監査可能性、悪影響の最小化と報告、トレードオフ、および救済が含まれています。責任の概念は、当事者の行動または不作為を補償する既存の法律および規制がある限り、信頼できるAIに含まれます。ただし、そのような補償は要件として明示的には含まれていません。

責任あるAIには、情報工学者であるバージニア・ディグナムによる別の定義があります。

この見解は、AIに対する包括的な観点(例えば、倫理的または道徳的だけでなく、法的、文化的、社会経済的観点)を提供しており、AIシステムの開発と展開を強調しています。AIはテクノロジーだけでなく、人間のシステム、プロセス、ガバナンスに対して重要な視点を置くことで、AIシステムの有益な性質を評価および決定することができます。

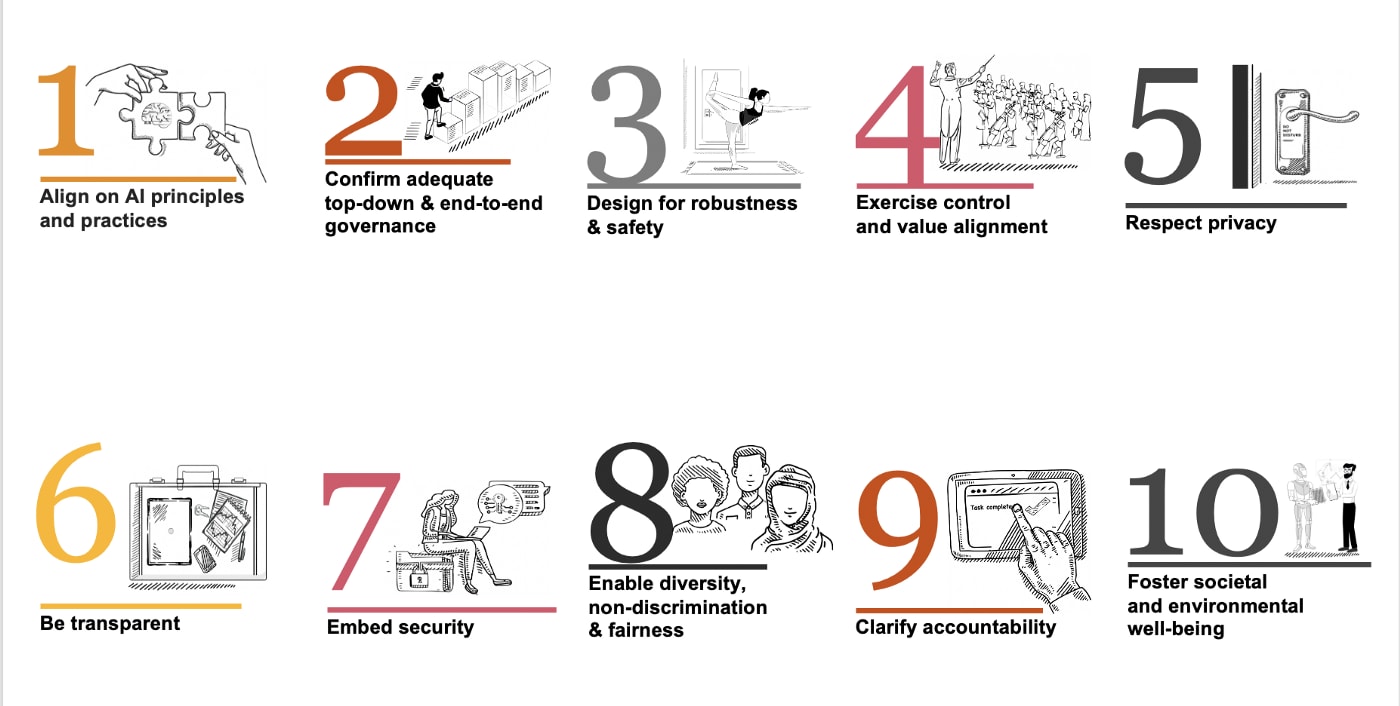

ここまでの議論で、AIを利活用するにあたって企業が責任を果たすべき10のAI原則を提示する準備が整いました。この10の原則は、「信頼できるAI」「倫理的なAI」「有益なAI」「責任あるAI」の定義から導き出されています。また、ここでの焦点は、上記に記載した信頼できるAIの実現に関係する利害関係者の1つであるAIシステムを構築/展開/購入/使用している企業にあります。

図1:企業がAIを利活用するにあたって果たすべき10のAI原則

(Ten Principles of Responsible AI for Corporates:https://towardsdatascience.com/ten-principles-of-responsible-ai-for-corporates-dd85ca509da9 より引用。作成はPwC)

なお、上述した諸原則の多くは、過去数年の間に多数の企業や、非営利団体、コンソーシアム、専門家団体、各国政府、規制機関が、共通の原則の統合と合意に努める中で発展してきたものです。

※本稿はPwCが寄稿したTen Principles of Responsible AI for Corporatesの一部を翻訳、加工したものです。

{{item.text}}

{{item.text}}

{{item.text}}

{{item.text}}